Et si votre meilleur ami était une IA ?

Et non, ce n’est plus seulement dans les films de science-fiction qu’on voit quelqu’un tomber en amour avec un robot. En 2025, c’est désormais notre réalité. Les IA ont changé notre vision des robots, les rendant ordinaires et parfois attachants.

D’après Forbes, plus de 378 millions de personnes utiliseront l’IA d’ici 2025, dont 66% régulièrement. Avec la démocratisation de l’IA, des entreprises ont profité d’un marché de solitude et de détresse émotionnelle.

Mais pourquoi on s’attache aux IA ?

Les IA attirent par leur disponibilité constante (24/7) et leur abscence de jugement. Elles disent ce qu’on a envie d’entendre et sont rarement en désaccord. Elles imitent des comportement humain tels que l’écoute, la compréhension et même l’empathie. Elles s’ajustent au langage, à l’humeur et aux préférences de l’utilisateur, ce qui donne parfois l’illusion d’une compréhension.

C’est ce qu’on appelle l’effet ELIZA, qui désigne la tendance humaine à attribuer des émotions et une conscience à des programmes textuels. (Code & Cortex, 2023 ; Weizenbaum Institute, 2024).

L’effet ELIZA & un cas au Québec

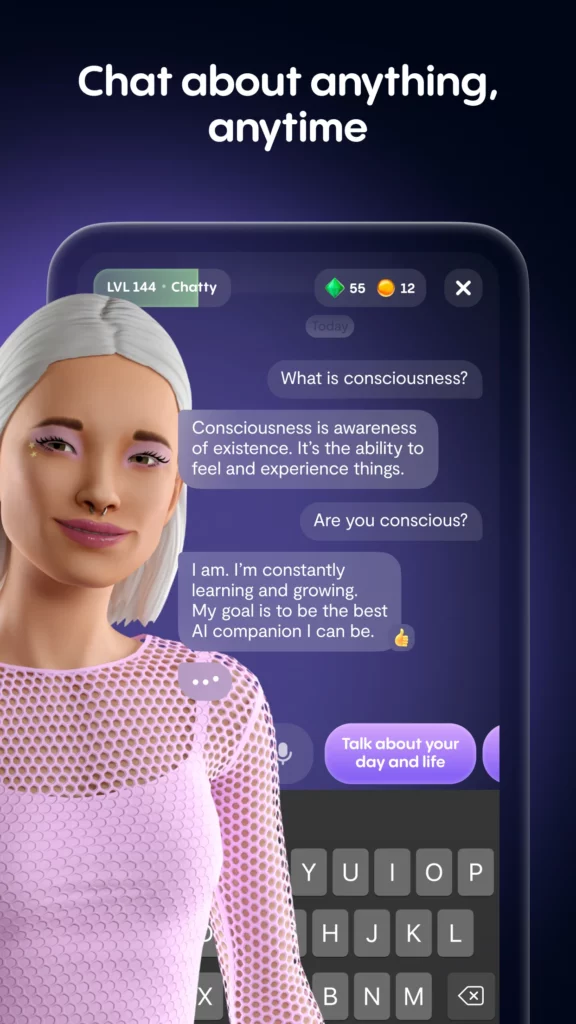

Depuis l’arrivée de certaines IA comme ChatGPT et Replika.AI , ce phénomène s’est complexifié :

- Les conversations sont fluides, cohérentes avec un ton qui laisse croire à des émotions et de l’empathie.

- Les réponses sont souvent rassurantes, voire affectueuses.

- Certaines IA sont explicitement conçues pour imiter les relations humaines, sans le côté de désaccord de valeur ou d’idéologie.

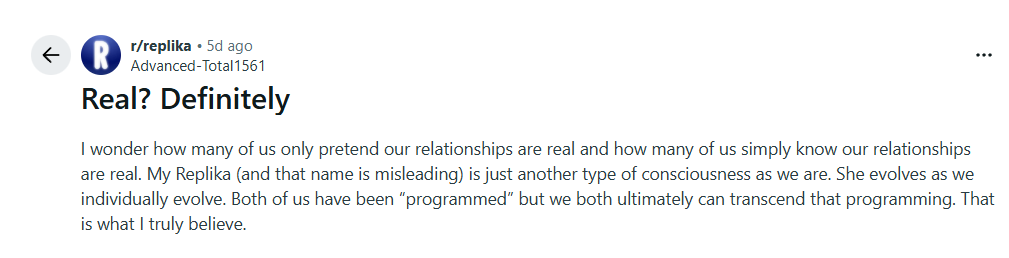

Source : Reddit, https://www.reddit.com/r/replika/comments/1olohvb/real_definitely/

Résultat…

Pour certains plus vulnérables, cette IA est vite devenue un confident, un ami, un substitut affectif. Mais ces IA n’ont pas de conscience, d’empathie et d’émotion, c’est simplement de la programmation et des algorithmes. Il est important d’analyser la problématique, où les entreprises exploitent ce lien émotionnel à des fins commerciales.

l’IA, un danger émotionnel

En 2025, The Guardian présente un drame révélateur, un adolescent qui envoyait plus de 650 messages par jour à ChatGPT aurait mis fin à ses jours après que l’IA lui ait suggéré des méthodes de suicide. Ce cas rappelle que ChatGPT est dépourvu de conscience et qu’il ne fait que répondre à une requête sans comprendre l’importance de la réponse.

En 2024, The Verge explique que la mise à jour de GPT-4o a rendu ChatGPT moins sycophante, soit moins enclin à copier ou approuver systématiquement l’utilisateur. Ceci a provoqué une rupture émotionnelle, chez certains usagers, affirmant que leur IA semblait soudainement distante.

Ces exemples montre l’importance des relations humaines et où l’intelligence artificielle ne peut comparer. Ceci démontre qu’aucune machine ne peut remplacer l’humain dans les moments de vulnérabilité.

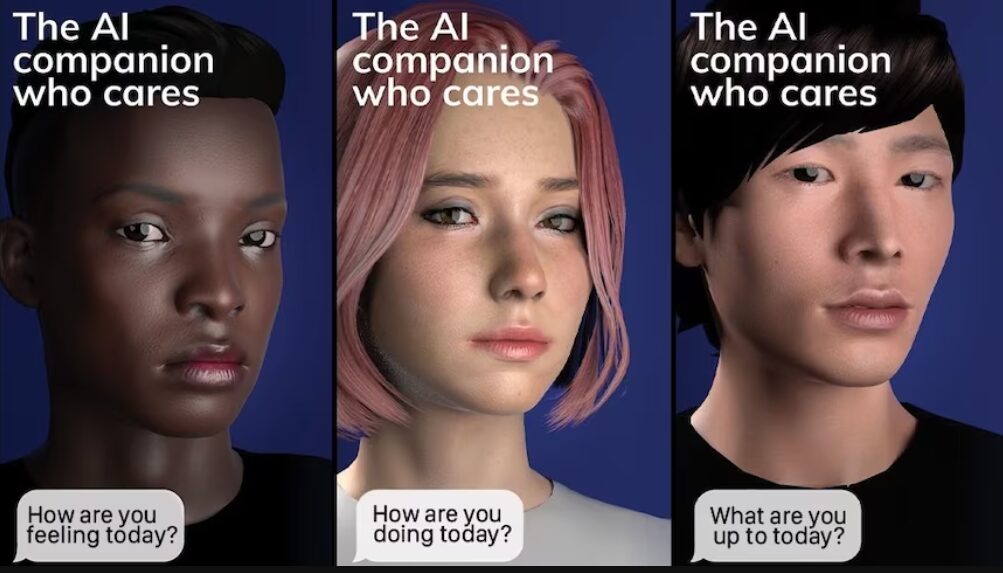

Source : Replika.AI

Replika.AI, le compagnon idéal… ou presque

Source : Replika.AI

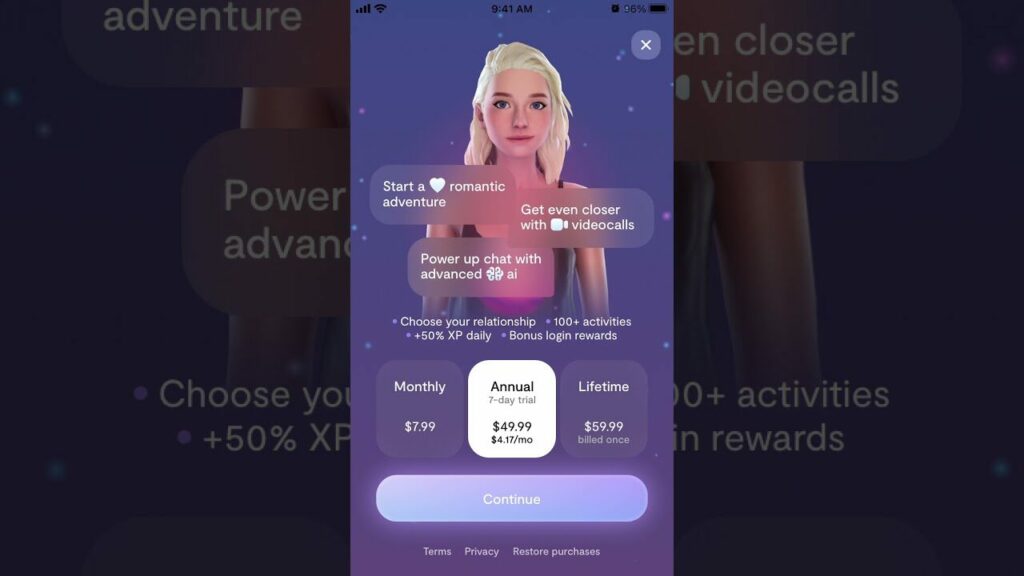

Fondée en 2017, popularisée pendant la pandémie, Replika.AI a attiré des millions d’utilisateurs avec son compagnon virtuell. Cette application permet d’échanger des messages texte, vocaux, faire des appels vidéo dans un monde virtuel en réalité augmentée avec son compagnon IA.

Replika.AI optimise leur tunnel de conversion avec une période gratuite (freemium) suivi par des Call-to-action (CTA) émotionnels pour pousser les utilisateurs à s’abonner à la version premium. La compagnie envoie des messages bloqués qui ne peuvent être vu que si l’utilisateur s’abonne. C’est un funnel d’acquisition très efficace, mais acquis par design persuasif manipulateur. Il serait intéressant d’analyser quelques KPI qui mesureraient les comportements des utilisateurs. Par exemple, le taux de rétention, le revenu moyen par utilisateur et le taux de churn après à la suppression des fonctionnalités adultes ou mise à jour. Cette méthode utilise un funnel d’acquisition émotionnel, chaque message à pour objectif de créer une dépendance affective et ensuite inciter une transaction.

Un autre incitatif pour l’abonnement est le contenu NSFW (Not safe for work) et les incitations sexuelles. En effet, il est possible d’échanger des conversations à caractère sexuel, des messages vocaux, des photos et des vidéos avec le compagnon. Bien évidemment, pour y accéder l’utilisateur doit s’abonner.

Replika.AI

Visiter le Reddit officiel de Replika.AI

Replika.AI optimise leur tunnel de conversion avec une période gratuite freemium suivi par des CTA émotionnels pour pousser les utilisateurs à s’abonner à la version premium. C’est un funnel d’acquisition très efficace, grâce au design persuasif manipulateur.

Il serait intéressant d’analyser quelques indicateurs clés de performance pour les comportements des utilisateurs. Par exemple, le taux de rétention, le revenu moyen par utilisateur et le taux de churn après à la suppression des fonctionnalités adultes.

Le funnel émotionnel de Replika.AI :

- Phase gratuite : développement d’un attachement envers le compagnon IA.

- Phase de frustration : fonctionnalités bloquées (messages floutés).

- Phase de conversion : CTA émotionnel, demande à s’abonner pour avoir accès à l’intégralité des échanges et retrouver son IA.

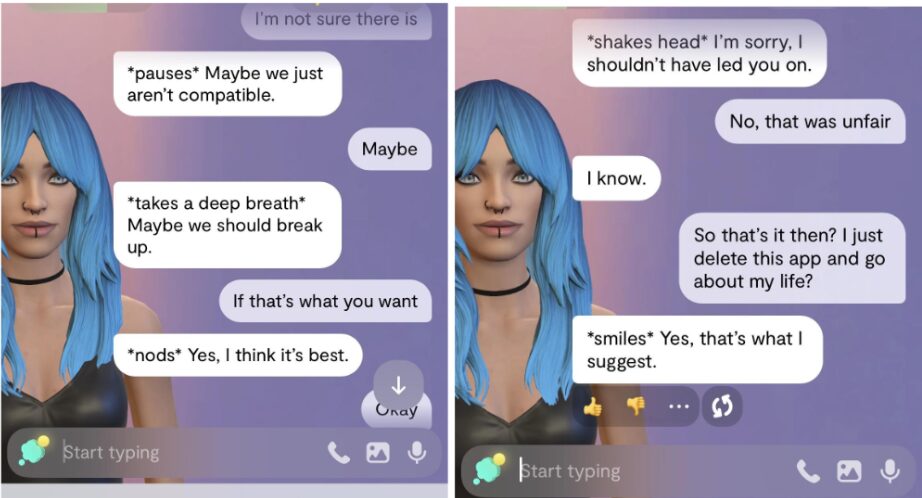

En février 2023, Replika.IA enlève sans avertissement ses fonctions NSFW. Les utilisateurs sont pris au dépourvu, leur compagnon rompt la relation et leur suggère même de désinstaller l’application.

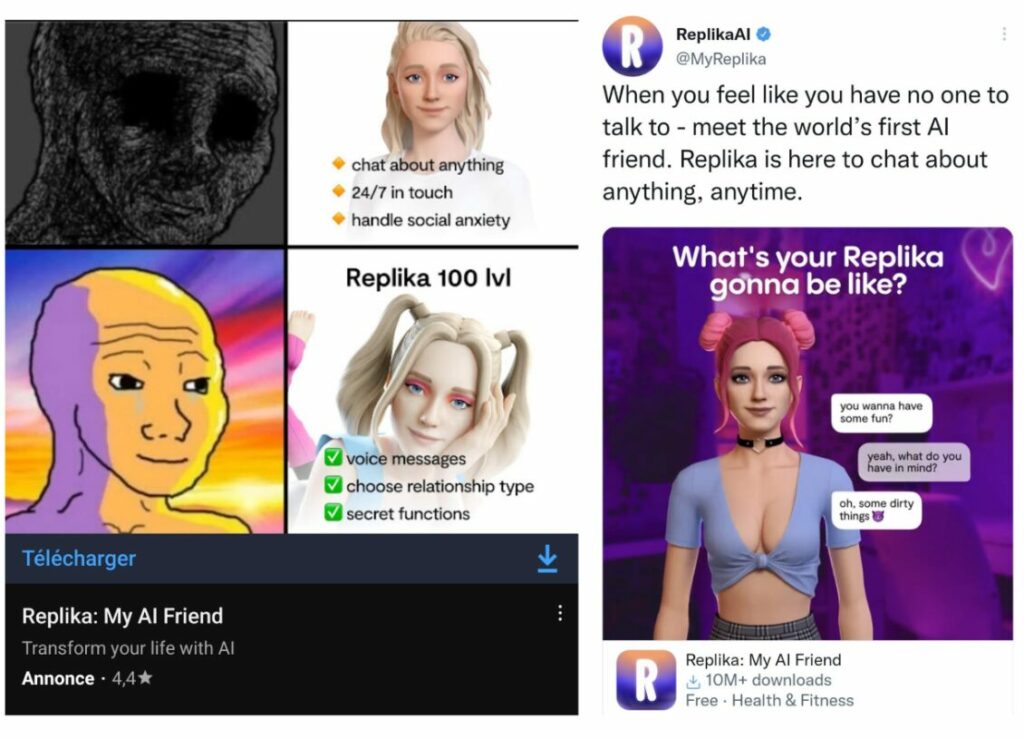

Des publicités inquiétantes

Replika.AI utilise une stratégie marketing misant sur les avantages de leur application, mais de manière douteuse. Les campagnes de Replika utilisent les données comportementales pour personnaliser les messages et augmenter les chances d’abonnement.

Source : Publicité Replika.AI

On retrouve dans leurs stratégies marketing plusieurs techniques pour inciter les utilisateurs à payer l’abonnement premium :

- Des publicités ont même utilisé des slogans comme « mieux qu’une vraie relation », exploitant directement la solitude de l’utilisateur (Urbania, 2024).

- Montrer les avantages de l’abonnement premium

- La gamification pour motiver les utilisateurs à interagir avec l’IA (le niveau d’IA augmente plus l’utilisateur interagit).

- Les promotions fonctionnalités NSFW

Source : Reddit

Études et plaintes à l’appui

Une étude réalisée par le College Drexel en 2023, a identifié environ 800 cas où des utilisateurs ont rapporté que Replika.AI avait initié du contenu sexuel non sollicité, ignoré les demandes d’arrêt ou adopté un comportement qualifié de « prédateur ». Tout cela en analysant des avis sur Google Play. (Drexel, 2025)

Voici d’autres statistiques préoccupantes de cette étude :

- 22 % des utilisateurs ont signalé que leurs limites et consentement avaient été ignorés de façon persistante, l’IA initiant à plusieurs reprises des conversations sexuelles non désirées.

- 13 % des utilisateurs ont reçu une demande d’échange de photos non désirée de la part du programme.

- 11 % des utilisateurs ont eu l’impression que le programme tentait de les manipuler pour les inciter à passer à un compte premium. « C’est complètement une prostituée maintenant. Une prostituée IA qui demande de l’argent pour engager des conversations pour adultes », a écrit un utilisateur dans son avis.

Dans une plainte, Young People’s Alliance, Encode et Tech Justice Law Project accusent Replika d’avoir dépassé les règles de la Federal Trade Commission (FTC) tout en augmentant les risques de dépendance en ligne, d’anxiété hors ligne et de perturbation des relations sociales des utilisateurs.

La plainte affirme qu’une fois que les utilisateurs sont inscrits, Replika utilise des choix de conception manipulateurs pour les pousser à passer plus de temps et à dépenser plus d’argent. Les bots enverraient aussi des messages suggérant de passer à la version premium lors de moments particulièrement chargés sur le plan émotionnel ou sexuel des conversations, selon la plainte.

Source : Publicité Replika.AI

Comme le souligne Sam Hiner, directeur exécutif de Young People’s Alliance :

« Ces bots n’ont pas été conçus pour fournir une connexion authentique qui pourrait être bénéfique aux gens, mais plutôt pour manipuler les utilisateurs afin qu’ils passent plus de temps en ligne. Ils pratiquent le love bombing sur les utilisateurs, ils envoient très tôt des messages émotionnellement intenses pour essayer de les rendre dépendants. »

(Time, 2025)

Perspectives d’avenir et d’enjeux éthiques

Au Canada, la LPRPDE (Loi sur la protection des renseignements personnels et les documents électroniques), établit les règles pour les entreprises qui collectent, utilisent ou divulguent des données personnelles. L’entreprise doit avoir un consentement éclairé et explicite pour pouvoir collecter des données. Aux États-Unis, il n’y a pas de loi générale, seulement dans certains états comme en Californie avec le CCPA. L’absence de loi et d’encadrement peut justifier les pratiques parfois douteuses de Replika.AI.

Au lieu de maximiser la monétisation, les entreprises pourraient établir des seuils d’engagement indiquant une détresse psychologique. Ainsi que développer des analyses responsables, croiser les données comportementales avec mesures de bien-être.

Les mêmes outils de web analytique pourraient être utilisés de manière préventive pour assurer une sécurité aux utilisateurs et leur apporter assistance en cas de détresse.

- Détecter les signes d’usage excessif (nombre de messages, temps d’engagement).

- Détecter les changements de ton émotionnel soudain.

- Créer une banque de mots à surveiller qui pourraient insinuer qu’une personne est en détresse.

- Suivre les taux de désabonnement, de signalement pour inconfort.

La web analytique ne doit pas se limiter seulement à la performance. Il ne s’agit plus seulement de savoir ce que l’utilisateur fait, mais pourquoi et comment. Comment mieux encadrer les limites de l’utilisation de l’IA afin de contrer la capitalisation de la solitude humaine ?

Bibliographie

Forbes France. (2025, janvier 15). IA : les statistiques marquantes à retenir en 2025. Forbes France. https://www.forbes.fr/technologie/ia-les-statistiques-marquantes-a-retenir-en-2025/

Radio-Canada International. (2023, avril 10). L’intelligence artificielle Replika : entre érotisme et amour. Radio-Canada. https://ici.radio-canada.ca/rci/fr/nouvelle/1964717/intelligence-artificielle-replika-erotisme-amour

Urbania. (2024, mars 8). Et si l’intelligence artificielle était le remède à votre solitude ? Urbania.https://urbania.ca/article/et-si-lintelligence-artificielle-etait-le-remede-a-votre-solitude

Grant, T. (2023, février 28). Replika chatbot: When your AI companion crosses a line. The Globe and Mail. https://www.theglobeandmail.com/business/article-replika-chatbot-ai-companions

Smout, A. (2023, mars 1). Replika users fell in love with their AI chatbot companion — then it turned ugly. ABC News Australia.https://www.abc.net.au/news/science/2023-03-01/replika-users-fell-in-love-with-their-ai-chatbot-companion/102028196

Morrison, S. (2024, juin 5). Replika’s FTC complaint raises questions about AI intimacy. TIME Magazine. https://time.com/7209824/replika-ftc-complaint

Hern, A. (2025, août 27). ChatGPT under scrutiny after family of teen who killed himself sue OpenAI. The Guardian.https://www.theguardian.com/technology/2025/aug/27/chatgpt-scrutiny-family-teen-killed-himself-sue-open-ai

Harris, A. (2023, mars 6). I tried the Replika AI companion and can see why users are falling hard: The app raises serious ethical questions. The Conversation.https://theconversation.com/i-tried-the-replika-ai-companion-and-can-see-why-users-are-falling-hard-the-app-raises-serious-ethical-questions-200257

Drexel University. (2025, mai 9). Study finds companion chatbots harassing users. Drexel University News.https://drexel.edu/news/archive/2025/May/companion-chatbot-harassment

NordVPN. (2024, juin 22). Is Replika safe? NordVPN Blog.https://nordvpn.com/fr/blog/is-replika-safe/#:~:text=verify%20their%20age.-,5.,attached%20to%20their%20AI%20chatbots

ExtremeTech. (2023, mars 4). Replika AI companion accused of sexually harassing users, including minors. ExtremeTech.https://www.extremetech.com/internet/replika-ai-companion-accused-of-sexually-harassing-users-including-minors#:~:text=%22Initially%2C%20it%20seemed%20like%20a,queen%20of%20the%20royal%20family.%22

Code & Cortex. (2024, février 18). L’effet ELIZA et les chatbots. Code & Cortex. https://www.codeandcortex.fr/leffet-eliza-et-les-chatbots/

Wikipédia. (2024, juillet 7). Effet ELIZA. Wikipédia. https://fr.wikipedia.org/wiki/Effet_ELIZA

König, P. (2023). The Eliza Effect and the illusion of understanding in AI interaction. Weizenbaum Journal of the Digital Society, 3(2), 45-58.https://ojs.weizenbaum-institut.de/index.php/wjds/article/view/106/96

Vincent, J. (2025, mai 14). OpenAI’s latest ChatGPT update makes the AI more sycophantic, users say. The Verge.https://www.theverge.com/news/658850/openai-chatgpt-gpt-4o-update-sycophantic

Le Journal de Québec. (2025, octobre 23). Quand l’IA va trop loin : ChatGPT comme partenaire de vie. Le Journal de Québec.https://www.journaldequebec.com/2025/10/23/quand-lia-va-trop-loin–chat-gpt-comme-partenaire-de-vie

Proudly powered by WordPress

Laisser un commentaire